Table of Contents

Ziel

In dem zweiten Teil dieser Serie wird die Oracle Database 11g Release 2 installiert.

Voraussetzungen

Die Voraussetzungen für die Installation der Oracle Database ist die Installation der Oracle Grid Infrastructure, die in Teil 1 dieser Blogserie durchgeführt wurde. Hier zu finden.

Der Download der Oracle Database 11g Release 2 kann entweder über das Oracle Technology Network (http://otn.oracle.com) oder über E-Delivery (http://edelivery.oracle.com). Für die Installation müssen beide Installationsteile heruntergeladen werden.

Für die Demonstration der Installation habe ich die beiden ZIP Dateien in das Verzeichnis /u01/app/oracle/software auf dem ersten RAC Knoten entpackt.

Installation

Um die Installation zu starten muss das runInstaller Skript ausgeführt.

[oracle@rac01-1 ~]$ cd /u01/app/oracle/software/database/ [oracle@rac01-1 database]$ ./runInstaller

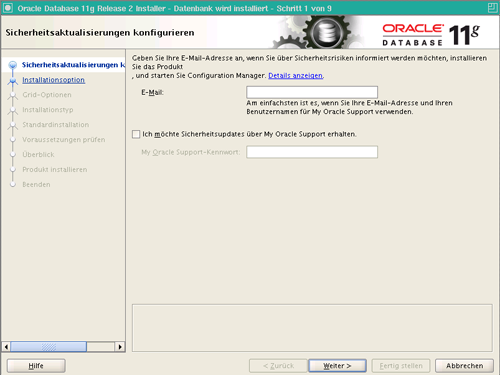

Es öffnet sich das folgende Fenster.

Die Verknüpfung mit My Oracle Support (MOS) nehme ich an dieser Stelle nicht vor. In Produktivumgebungen ist die Angabe der Logindaten empfehlenswert, da man dadurch zum Beispiel über die neusten Patches informiert wird und im Falle eines Service Requests der Oracle Support schneller reagieren kann. Wird der Haken entfernt erscheint beim Vorfahren der Installation eine Warnmeldung, die bestätigt werden muss.

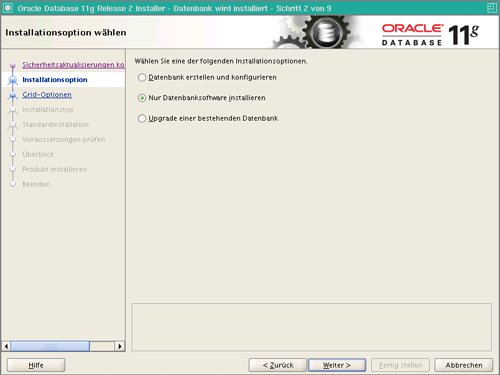

Im nächsten Schritt wird die Installationsart ausgewählt. An dieser Stelle wird lediglich die Software installiert. Die Konfiguration der Datenbank wird im nächsten Teil der Serie beschrieben.

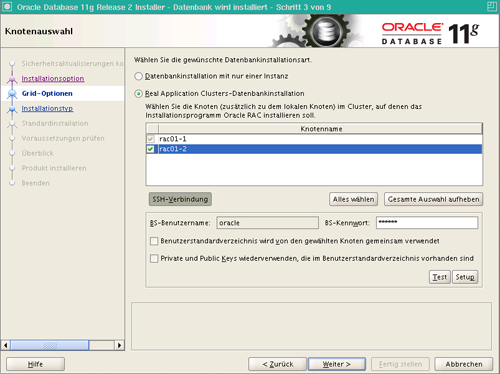

Unter den Grid-Optionen wird die SSH Konnektivität zwischen den Knoten konfiguriert. Wie schon in Teil 1 der Serie beschrieben, ist das Konfigurieren der SSH Konnektivität im Installer ein neues Feature von 11g Release 2. Für das Setup muss zunächst das Passwort des Installationsbenutzer eingegeben. Anschließend übernimmt Oracle alle weiteren Schritte nach Bestätigung der Setup Schaltfläche. Wichtig dabei ist, dass alle Knoten ausgewählt sind.

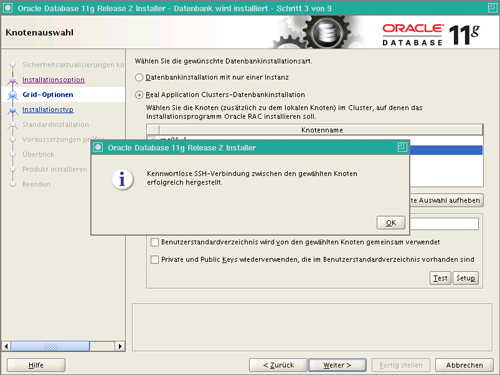

Der Erfolg der Durchführung wird mit einem Popup-Fenster bestätigt.

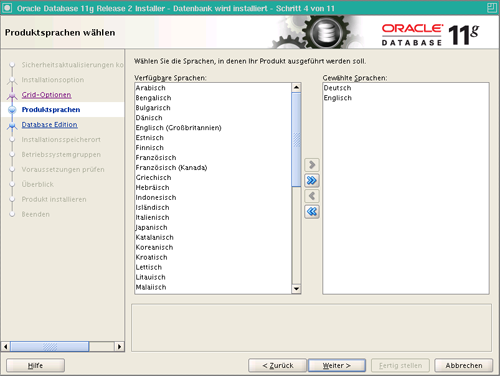

Auf der folgenden Seite kann die gewünschte Sprache ausgewählt werden. Neben der Standardsprache Englisch werde ich Deutsch installieren.

Für die Demonstration weiterer Funktionen von Oracle werde ich die Enterprise Edition installieren, um den größst möglichen Funktionsumfang zu erhalten. Es werden die Standard-Optionen verwendet.

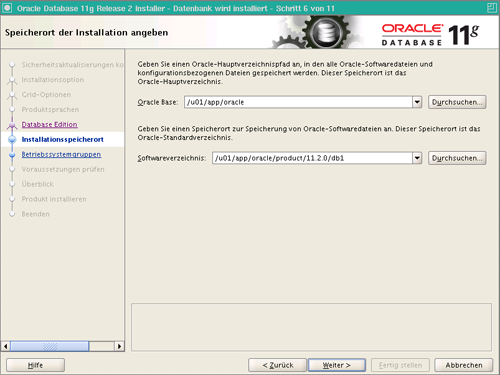

Als nächstes muss das Installationsverzeichnis angegeben werden. Durch die Oracle Flexible Architecture (OFA) schlägt Oracle bereits den richtigen Pfad vor.

Die benötigten Betriebssystemgruppen zur Verwaltung der Berechtigungen erkennt Oracle ebenfalls automatisch, wenn die Standardnamen (dba und oper) verwendet werden.

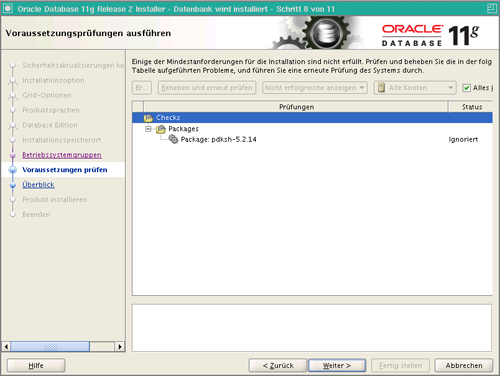

Im letzten Schritt überprüft der Installer die Voraussetzungen für die Installation. Sollte es zu Problemen kommen, können sogenannte Fixup Skripte erzeugt werden, die als root Benutzer auszuführen sind. Mithilfe dieser Skripte lassen sich viele Probleme lösen, aber nicht alle. Bei der Installation unter CentOS wird das Paket pdksh als fehlend gemeldet. Diese Warnung kann ignoriert werden. Durch Setzen des Hakens bei Alles ignorieren werden die gemeldeten Fehler ignoriert und die Installation kann vorgesetzt werden.

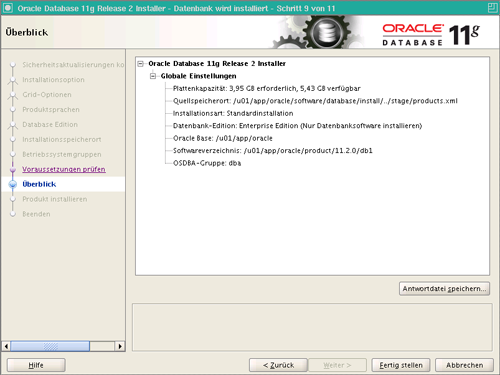

Bevor die Installation startet, wird eine kurze Zusammenfassung angezeigt. An dieser Stelle ist es möglich die vorgenommenen Einstellungen als sogenannte Response File zu sichern. Bei einer erneuten Installation kann dann auf diese Datei zurück gegriffen werden. Dies erspart das erneute Eingeben der Informationen.

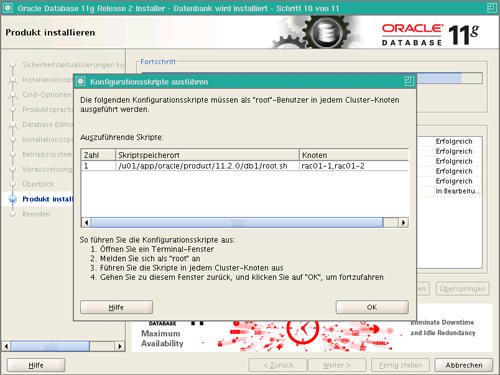

Zum Abschluss der Installation muss das root.sh Skript auf jedem Knoten ausgeführt werden.

Ausführung des root.sh Skriptes auf rac01-1

[root@rac01-1 ~]# /u01/app/oracle/product/11.2.0/db1/root.sh Running Oracle 11g root.sh script... The following environment variables are set as: ORACLE_OWNER= oracle ORACLE_HOME= /u01/app/oracle/product/11.2.0/db1 Enter the full pathname of the local bin directory: [/usr/local/bin]: The file "dbhome" already exists in /usr/local/bin. Overwrite it? (y/n) [n]: y Copying dbhome to /usr/local/bin .. The file "oraenv" already exists in /usr/local/bin. Overwrite it? (y/n) [n]: y Copying oraenv to /usr/local/bin ... The file "coraenv" already exists in /usr/local/bin. Overwrite it? (y/n) [n]: y Copying coraenv to /usr/local/bin ... Entries will be added to the /etc/oratab file as needed by Database Configuration Assistant when a database is created Finished running generic part of root.sh script. Now product-specific root actions will be performed. Finished product-specific root actions.

Ausführung des root.sh Skriptes auf rac01-2

[root@rac01-2 ~]# /u01/app/oracle/product/11.2.0/db1/root.sh Running Oracle 11g root.sh script... The following environment variables are set as: ORACLE_OWNER= oracle ORACLE_HOME= /u01/app/oracle/product/11.2.0/db1 Enter the full pathname of the local bin directory: [/usr/local/bin]: The file "dbhome" already exists in /usr/local/bin. Overwrite it? (y/n) [n]: y Copying dbhome to /usr/local/bin ... The file "oraenv" already exists in /usr/local/bin. Overwrite it? (y/n) [n]: y Copying oraenv to /usr/local/bin ... The file "coraenv" already exists in /usr/local/bin. Overwrite it? (y/n) [n]: y Copying coraenv to /usr/local/bin ... Entries will be added to the /etc/oratab file as needed by Database Configuration Assistant when a database is created Finished running generic part of root.sh script. Now product-specific root actions will be performed. Finished product-specific root actions.

Nachdem beide Skripte erfolgreich durchlaufen sind, kann das Popup Fenster über die Schaltfläche OK geschlossen werden. Die Installation ist nun abgeschlossen.

ASM Disks vorbereiten

Für die Erstellung der Datenbank im nächsten Teil dieser Serie, werden zwei weitere Diskgruppen zur Veranschaulichung benötigt. Eine Diskgruppe für die Datenbankdateien (+DATA) und eine Diskgruppe für die Flash Recovery Area (+FRA).

Zu diesem Zweck wurden zwei weitere iSCSI Targets im OpenFiler definiert.

Für die Arbeiten an der iSCSI Konfiguration müssen die Cluster Registry Services gestoppt werden. Ohne das Stoppen würde durch den Neustart die Verbindung zur ASM Diskgruppe mit der Clusterkonfiguration verloren gehen. Ein Neustart des Knotens wäre die Folge.

[root@rac01-1 ~]# /u01/app/11.2.0/grid/bin/crsctl stop crs CRS-2791: Herunterfahren der von Oracle High Availability Services verwalteten Ressourcen auf "rac01-2" wird gestartet CRS-2673: Versuch, "ora.crsd" auf "rac01-1" zu stoppen CRS-2790: Herunterfahren der von Cluster Ready Services verwalteten Ressourcen auf 'rac01-1' wird gestartet CRS-2673: Versuch, "ora.CONFIG.dg" auf "rac01-1" zu stoppen CRS-2673: Versuch, "ora.LISTENER_SCAN1.lsnr" auf "rac01-1" zu stoppen CRS-2673: Versuch, "ora.LISTENER.lsnr" auf "rac01-1" zu stoppen CRS-2677: Stoppen von "ora.LISTENER.lsnr" auf "rac01-1" erfolgreich CRS-2673: Versuch, "ora.rac01-1.vip" auf "rac01-1" zu stoppen CRS-2677: Stoppen von "ora.LISTENER_SCAN1.lsnr" auf "rac01-1" erfolgreich CRS-2673: Versuch, "ora.scan1.vip" auf "rac01-1" zu stoppen CRS-2677: Stoppen von "ora.rac01-1.vip" auf "rac01-1" erfolgreich CRS-2672: Versuch, "ora.rac01-1.vip" auf "rac01-2" zu starten CRS-2677: Stoppen von "ora.scan1.vip" auf "rac01-1" erfolgreich CRS-2672: Versuch, "ora.scan1.vip" auf "rac01-2" zu starten CRS-2676: Starten von "ora.rac01-2.vip" auf "rac01-2" erfolgreich CRS-2676: Starten von "ora.scan1.vip" auf "rac01-2" erfolgreich CRS-2672: Versuch, "ora.LISTENER_SCAN1.lsnr" auf "rac01-2" zu starten CRS-2676: Starten von "ora.LISTENER_SCAN1.lsnr" auf "rac01-2" erfolgreich CRS-2677: Stoppen von "ora.CONFIG.dg" auf "rac01-1" erfolgreich CRS-2673: Versuch, "ora.asm" auf "rac01-1" zu stoppen CRS-2677: Stoppen von "ora.asm" auf "rac01-1" erfolgreich CRS-2673: Versuch, "ora.eons" auf "rac01-1" zu stoppen CRS-2673: Versuch, "ora.ons" auf "rac01-1" zu stoppen CRS-2677: Stoppen von "ora.ons" auf "rac01-1" erfolgreich CRS-2673: Versuch, "ora.net1.network" auf "rac01-1" zu stoppen CRS-2677: Stoppen von "ora.net1.network" auf "rac01-1" erfolgreich CRS-2677: Stoppen von "ora.eons" auf "rac01-1" erfolgreich CRS-2792: Herunterfahren der von Cluster Ready Services verwalteten Ressourcen auf 'rac01-1' ist abgeschlossen CRS-2677: Stoppen von "ora.crsd" auf "rac01-1" erfolgreich CRS-2673: Versuch, "ora.mdnsd" auf "rac01-1" zu stoppen CRS-2673: Versuch, "ora.gpnpd" auf "rac01-1" zu stoppen CRS-2673: Versuch, "ora.cssdmonitor" auf "rac01-1" zu stoppen CRS-2673: Versuch, "ora.ctssd" auf "rac01-1" zu stoppen CRS-2673: Versuch, "ora.evmd" auf "rac01-1" zu stoppen CRS-2673: Versuch, "ora.asm" auf "rac01-1" zu stoppen CRS-2677: Stoppen von "ora.cssdmonitor" auf "rac01-1" erfolgreich CRS-2677: Stoppen von "ora.mdnsd" auf "rac01-1" erfolgreich CRS-2677: Stoppen von "ora.gpnpd" auf "rac01-1" erfolgreich CRS-2677: Stoppen von "ora.evmd" auf "rac01-1" erfolgreich CRS-2677: Stoppen von "ora.ctssd" auf "rac01-1" erfolgreich CRS-2677: Stoppen von "ora.asm" auf "rac01-1" erfolgreich CRS-2673: Versuch, "ora.cssd" auf "rac01-1" zu stoppen CRS-2677: Stoppen von "ora.cssd" auf "rac01-1" erfolgreich CRS-2673: Versuch, "ora.diskmon" auf "rac01-1" zu stoppen CRS-2673: Versuch, "ora.gipcd" auf "rac01-1" zu stoppen CRS-2677: Stoppen von "ora.gipcd" auf "rac01-1" erfolgreich CRS-2677: Stoppen von "ora.diskmon" auf "rac01-1" erfolgreich >CRS-2793: Herunterfahren der von Oracle High Availability Services verwalteten Ressourcen auf "rac01-1" ist abgeschlossen CRS-4133: Oracle High Availability Services has been stopped.

Nachdem die CRS gestoppt wurden, können nun die iSCSI Targets eingebunden werden. Zunächst werden die neuen Ziele ermittelt.

[root@rac01-1 ~]# iscsiadm -m discovery -t sendtargets -p 192.168.100.160 192.168.100.160:3260,1 iqn.2006-01.com.openfiler:tsn.d32627e85ff1 192.168.100.160:3260,1 iqn.2006-01.com.openfiler:tsn.dc98ac738640 192.168.100.160:3260,1 iqn.2006-01.com.openfiler:tsn.3b1b9155dd4f

Anschließend wird der iscsi Deamon neugestartet.

[root@rac01-1 ~]# /etc/init.d/iscsi restart Logging out of session [sid: 1, target: iqn.2006-01.com.openfiler:tsn.3b1b9155dd4f, portal: 192.168.100.160,3260] Logout of [sid: 1, target: iqn.2006-01.com.openfiler:tsn.3b1b9155dd4f, portal: 192.168.100.160,3260]: successful Stopping iSCSI daemon: iscsid tot, aber PID-Datei existiert [ OK ] Starting iSCSI daemon: [ OK ] [ OK ] iSCSI-Ziele werden konfiguriert: Logging in to [iface: default, target: iqn.2006-01.com.openfiler:tsn.d32627e85ff1, portal: 192.168.100.160,3260] Logging in to [iface: default, target: iqn.2006-01.com.openfiler:tsn.dc98ac738640, portal: 192.168.100.160,3260] Logging in to [iface: default, target: iqn.2006-01.com.openfiler:tsn.3b1b9155dd4f, portal: 192.168.100.160,3260] Login to [iface: default, target: iqn.2006-01.com.openfiler:tsn.d32627e85ff1, portal: 192.168.100.160,3260]: successful Login to [iface: default, target: iqn.2006-01.com.openfiler:tsn.dc98ac738640, portal: 192.168.100.160,3260]: successful Login to [iface: default, target: iqn.2006-01.com.openfiler:tsn.3b1b9155dd4f, portal: 192.168.100.160,3260]: successful [ OK ]

Im nächsten Schritt werden die neuen iSCSI Targets formatiert. In meinem Fall wurden die beiden Ziele als /dev/sdc bzw, /dev/sdd erkannt.

Die Formatierung erfolgt mit fdisk und muss für beide Ziele durchgeführt werden.

[root@rac01-1 ~]# fdisk /dev/sdc [root@rac01-1 ~]# fdisk /dev/sdd

Eingaben während der Formatierung: n -> p -> 1 -> <Enter> -> <Enter> -> w

Zum Abschluss der Vorbereitungen müssen die beiden neue Partitionen als ASM Disk gelabelt werden.

[root@rac01-1 ~]# /etc/init.d/oracleasm createdisk DATA1 /dev/sdd1 Marking disk "DATA1" as an ASM disk: [ OK ] [root@rac01-1 ~]# /etc/init.d/oracleasm createdisk FRA1 /dev/sdc1 Marking disk "FRA1" as an ASM disk: [ OK ]

Damit der zweite Knoten die neuen ASM Disk auch erkennt muss folgender Befehl auf dem zweiten Knoten ausgeführt werden.

[root@rac01-2 rac01-2]# /etc/init.d/oracleasm scandisks Scanning the system for Oracle ASMLib disks: [ OK ] [root@rac01-2 rac01-2]# /etc/init.d/oracleasm listdisks DATA1 DISK1 FRA1

Die neuen ASM Disks stehen nun zur Verwendung bereit. Die Oracle CRS können wieder gestartet werden.

[root@rac01-2 rac01-2]# /u01/app/11.2.0/grid/bin/crsctl start crs CRS-4123: Oracle High Availability Services has been started.

ASM Diskgruppen anlegen:

Für die Konfiguration der ASM Diskgruppen kann entweder der grafische ASM Konfigurationassistent (ASMCA) oder das Kommandozeilen-Werkzeug SQL*Plus verwendet werden. In diesem Blogeintrag werde ich den ASMCA verwenden.

Der ASMCA finden sich im Oracle Home der Grid Infrastructure. Somit muss dieser Assistent mit dem grid Benutzer ausgeführt werden.

[grid@rac01-1 ~]$ cd /u01/app/11.2.0/grid/bin/ [grid@rac01-1 bin]$ ./asmca

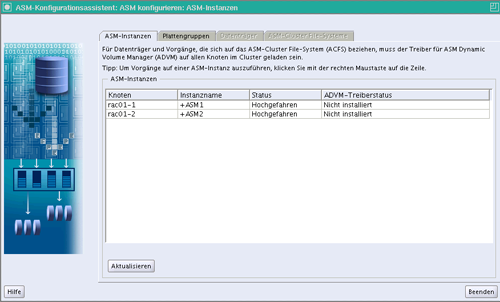

Es startet der folgende Dialog, auf dem man unter Anderem den Status der ASM Instanzen des Cluster erkennen kann.

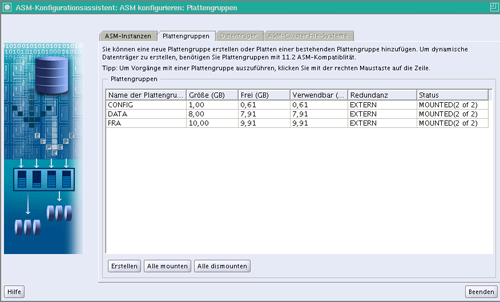

Die neuen Diskgruppen können unter dem Reiter Plattengruppen anlegt werden.

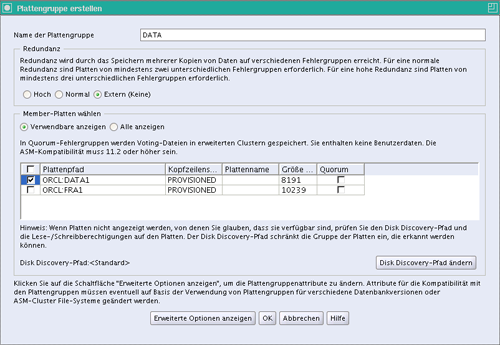

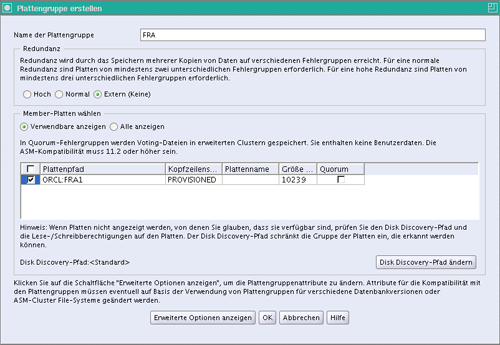

Wie man sieht existiert zurzeit nur die ASM Diskgruppe für die Cluster Konfiguration. Eine neue Diskgruppe legt man über die Schaltfläche Erstellen an. Es öffnet sich der folgende Dialog.

Für beide Diskgruppen wird die Spiegelung ausgeschaltet. In Produktivumgebungen sollte auf jeden Fall eine Spiegelung eingesetzt werden, entweder durch ein RAID System oder durch ASM.

Oracle bietet die zuvor erstellten ASM Disks als verwendbare Platten an. Dies erkennt man auch an dem Header Status PROVISONED der ASM Disk.

Nach dem Anlegen der neuen Diskgruppen sieht die Übersicht wie folgt aus.

Die neuen Diskgruppen können nun benutzt werden und der Konfigurationsassistent kann geschlossen werden.